Künstliche Intelligenz (KI) revolutioniert die Art und Weise, wie wir arbeiten und Geschäfte machen. Doch mit den großen Chancen kommen auch neue Verantwortlichkeiten. Der EU AI Act ist am 2. August in Kraft getreten und legt die Spielregeln für KI in Europa fest. Als kleines oder mittleres Unternehmen fragen Sie sich vielleicht, was das für Sie bedeutet. In diesem Artikel beleuchten wir die wichtigsten Aspekte des EU AI Act und erklären, worauf Sie sich vorbereiten sollten.

Mit dem EU AI Act strebt die Europäische Union eine Vorreiterrolle in der globalen KI-Regulierung an. Als erste umfassende KI-Gesetzgebung weltweit zielt sie darauf ab, einen einheitlichen Rechtsrahmen für alle Mitgliedsstaaten zu schaffen. Im Mittelpunkt steht dabei die Balance zwischen Innovationsförderung und dem sicheren, ethischen Einsatz von KI-Technologien. Durch einen risikobasierten Regulierungsansatz sollen die Grundrechte, die Sicherheit und die Gesundheit der EU-Bürger geschützt werden. Gleichzeitig soll das Vertrauen in KI-Systeme gestärkt und eine verantwortungsvolle Weiterentwicklung dieser Technologien gefördert werden. Besonderes Augenmerk liegt dabei auf der Unterstützung von KMU und Start-ups, um ihnen die Einhaltung der neuen Vorschriften zu erleichtern und so ein innovationsfreundliches Umfeld zu bewahren.

Die Risiko-Kategorien:

Der EU AI Act führt einen risikobasierten Ansatz ein, der KI-Systeme in verschiedene Kategorien einteilt. Diese Einteilung bestimmt den Grad der Regulierung und die Anforderungen an die jeweiligen Systeme:

1. Unannehmbares Risiko:

2. Hohes Risiko:

3. Begrenztes Risiko:

4. Minimales Risiko:

Wichtige Aspekte der Risikokategorisierung:

Diese differenzierte Herangehensweise ermöglicht es, die Regulierung an das tatsächliche Risikopotenzial anzupassen. So soll sichergestellt werden, dass hochriskante Anwendungen angemessen kontrolliert werden, während gleichzeitig Innovationen in weniger kritischen Bereichen nicht unnötig gehemmt werden.

Der EU AI Act sieht einen abgestuften Ansatz vor, der die Pflichten und Unterstützungsmaßnahmen an das jeweilige Risikoniveau des KI-Systems anpasst:

Minimales Risiko:

Begrenztes Risiko:

Hohes Risiko:

Zur Unterstützung der Entwicklung und Erprobung von KI-Systemen sieht die Verordnung „KI-Reallabore“ vor. Diese ermöglichen das Testen unter realen Bedingungen in einem kontrollierten Umfeld.

Diese differenzierte Herangehensweise zielt darauf ab, ein ausgewogenes Verhältnis zwischen effektiver Regulierung und Innovationsförderung zu schaffen.

Der EU AI Act sieht einen umfassenden Rahmen für die Governance und Durchsetzung der neuen KI-Regulierung vor.

Zentrale Elemente sind:

Diese Strukturen sollen eine einheitliche Anwendung der Verordnung in der gesamten EU gewährleisten. Zur Unterstützung der Transparenz und Überwachung wird eine EU-weite Datenbank für eigenständige Hochrisiko-KI-Systeme geschaffen.

Um die Einhaltung der Vorschriften sicherzustellen, sind empfindliche Sanktionen vorgesehen: Geldbußen bis zu 30 Mio. € oder 6% des weltweiten Jahresumsatzes bei Verstößen

Gleichzeitig werden Beschwerdeverfahren für Einzelpersonen und Organisationen eingerichtet, um eine effektive Durchsetzung zu gewährleisten. Die Verordnung fördert zudem die Zusammenarbeit zwischen nationalen Behörden und der EU-Kommission, um eine kohärente Umsetzung in allen Mitgliedstaaten zu erreichen.

Die Implementierung des EU AI Act erfolgt schrittweise, um allen Beteiligten ausreichend Zeit zur Anpassung zu geben:

Für bereits existierende KI-Systeme ist eine Übergangsfrist bis August 2026 vorgesehen. Dies gibt Unternehmen und Organisationen Zeit, ihre Systeme an die neuen Anforderungen anzupassen.

Um die Verordnung aktuell und effektiv zu halten, wird sie alle 24 Monate überprüft und gegebenenfalls an technologische Entwicklungen und neue Herausforderungen angepasst.

Dieser Zeitplan zeigt das Bestreben der EU, eine ausgewogene und schrittweise Einführung der KI-Regulierung zu gewährleisten, die sowohl den Schutz der Bürger als auch die Innovationsfähigkeit der Industrie berücksichtigt.

Die Reaktionen fielen tendenziell positiv aus. Der erste Entwurf brachte noch viel Kritik hervor wie z.B. überbordende Bürokratie, Wettbewerbsnachteile und zu strenge Bewertung. Im jetzt zur verabschiedeten Gesetz wurde manches vereinfacht und einiges entschärft, um die Innovationsfähigkeit der EU nicht zu gefährden. Viele gehen davon aus, dass der AI Act ähnlich wie schon die GDPR Datenschutz-Regulierung als Blaupause für andere Länder gelten wird. Entgegen aller Erwartungen wollen die großen Unternehmen bis zu einem gewissen Grad reguliert werden, um sichere Leitlinien und Planungssicherheit für die Weiterentwicklung zu haben. Dazu gibt es ein paar Unklarheiten: Was genau in der Praxis wirklich Hochrisikoanwendungen sind, oder wer die Umsetzung auf nationaler Ebene durchführt, ist z.B. noch gar nicht geklärt. Während der EU Act vorschreibt, dass Sprachmodelle beim Training nicht gegen das Urheberrecht verstoßen dürfen, gibt es im Urheberrecht selbst überhaupt keinen Bezug zu KI – bis es dazu eine Grundsatzentscheidung gibt, dürften bereits alle großen Modelle mit sämtlichen öffentlich verfügbaren Daten trainiert worden sein.

Dass Apple & Meta ihre neuen LLMs vorerst nicht in der EU veröffentlichen wollen, liegt übrigens nicht am AI Act sondern nach deren Aussage am Digital Markets Act, welcher die Marktmacht der Tech-Riesen regulieren soll. Viele deuten diese Ankündigungen aber auch als Machtspiel, da der DMA laut EU keinesfalls neue KI-Modelle einschränkt.

Finden Sie in 10 Minuten heraus, wie sich das KI-Gesetz auf Sie auswirken wird, indem Sie eine Reihe einfacher Fragen beantworten.

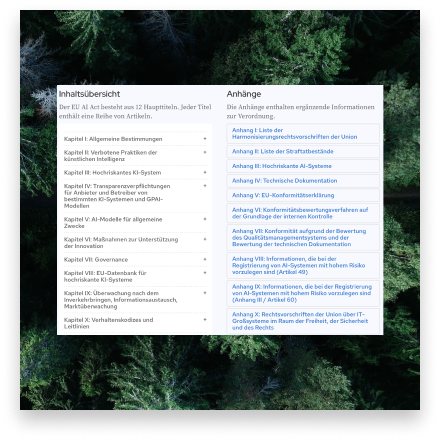

Durchsuchen Sie den vollständigen Text des AI-Gesetzes online. Suchen Sie innerhalb des Gesetzes nach Teilen, die für Sie relevant sind.

Der EU AI Act stellt sich als ausgewogener Rechtsrahmen dar, der Innovation fördert und gleichzeitig grundlegende Werte schützt. Für die meisten Unternehmen, die nicht an Hochrisiko-KI arbeiten, bleibt die Regulierung überschaubar. Der risikobasierte Ansatz, die Unterstützung für KMU und Start-ups sowie Maßnahmen wie KI-Reallabore zeigen, dass die EU ein innovationsfreundliches Umfeld schaffen will. Letztlich zielt die Verordnung darauf ab, Vertrauen in KI zu stärken und die EU als Vorreiter für ethische, sichere KI-Entwicklung zu positionieren – ohne dabei die Mehrheit der KI-Entwickler mit übermäßiger Bürokratie zu belasten.

Fakt ist auch: Es ändert sich sowieso ersteinmal gar nichts, weil mit der Timeline lediglich ein Prozess angestoßen wird. Die Umsetzung der ersten Verbote und Regeln wird dann ab 2025/26 zeigen, wie kontrollierbar das Gesetz überhaupt ist. Und so ein Jahr ist beim aktuellen KI-Fortschritt sehr lang…

„Bitte nicht aus unbegründeter Sorge auf KI-Innovationen verzichten! Einfach die eingesetzten KI-Anwendungen ehrlich evaluieren und dokumentieren – dann steht einem erfolgreichen Einsatz nichts im Wege!“

Sie haben weitere Fragen oder ein konkretes KI-Projekt bei dem Sie Unterstützung brauchen? Wir von eisbach partners arbeiten sowohl in den eigenen Ventures als auch bei Kundenprojekten bereits viel mit generativer KI. Kontaktieren Sie uns einfach!

eisbach partners ist eine auf nachhaltiges Wachstum spezialisierte Beratungsfirma, die Unternehmen unterstützt, langfristiges und erneuerbares Geschäftswachstum zu generieren, ohne dabei Umwelt und Lebensqualität zu gefährden. Sie arbeiten mit innovationsorientierten Führungskräften großer Unternehmen und erfolgreichen mittelständischen Unternehmen zusammen, um neue Chancen zu identifizieren, erste Umsätze zu generieren und nachhaltiges Wachstum zu liefern. eisbach partners verfolgt einen individuellen und maßgeschneiderten, unternehmerischen Ansatz, basierend auf der Erfahrung als erfolgreiche Unternehmer und Berater, um Seite an Seite mit ihren Kunden zu arbeiten und deren ungenutztes Potenzial zu mobilisieren.